Comme je l’ai indiqué dans mon article précédent sur les sources non académique, la fiabilité des témoignages rapportés et potentiellement déformés ou les mécanismes de mémoire déforment régulièrement la réalité. Il est donc nécessaire de garder un compte précis pour rester objectif et ne pas choisir uniquement les exemples qui nous intéressent.

C’est pour cela que les études publiées reposent sur différents outils statistiques.

Les statistiques descriptives, qui servent à structurer les données récoltées pour dresser le premier panorama d’une situation afin d’essayer de comprendre un phénomène.

Il est alors de coutume de proposer des représentations chiffrées et graphiques qui apportent des informations utilisables et de produire des probabilités d’occurrence d’un évènement.

La neutralité des statistiques évite de ne se souvenir que des cas qui nous arrangent

Le choix de la population étudiée ne dois pas présenter de biais de sélection (je ne choisis que les gens qui m’arrangent) mais doivent être le plus possible représentatif de la population que l’on souhaite étudier. Certains sujets peuvent aussi être affectés par un biais du survivant, les témoignages de personnes ayant survécu à un situation mortelle prenant alors une proportion plus importante que dans la réalité puisque ceux qui sont morts ne peuvent témoigner. D’autres problèmes peuvent survenir, notamment par la méthode de sélection reposant sur le bénévolat (seuls les gens intéressés par un sujet et ayant certains comportements participent).

La manière de sélectionner un échantillon sensé être représentatif de la population que l’on veut étudier est donc cruciale.

La taille de l’échantillon interrogé est aussi un problème. Il faut qu’il soit assez important pour pouvoir être représentatif de la population étudiée. Si je n’interroge que 4 personnes, je peux tomber sur 4 personnes « hors norme » mais si j’en contacte 100 c’est beaucoup moins probable et si c’est 1000 c’est encore plus rare. Plus la taille de l’échantillon est grande et plus son comportement sera proche de celui de la population étudiée. On parle de Loi des grands nombres.

Par exemple si vous jouez à pile ou face, une pièce non truquée lancée sans manipulation a en théorie une « chance » sur deux de tomber sur pile et la même « chance » sur face. Si vous faites l’expérience, il se peut que deux lancers de suite donnent face mais plus vous lancerez la pièce plus vous tendrez vers les 50% de pile et 50 de face.

La représentation graphique de ces probabilités permet de produire une courbe de loi statistique. La plus connue est celle dite de la Loi Normale et le Théorème central limite postule qu’une suite de variable tendra vers la loi normale. Mais elle nécessite un échantillon d’au moins 30 personnes pour commencer à pouvoir être utilisée. En dessous de cette taille, il est nécessaire d’utiliser des lois correctrices et la fiabilité est bien moindre. Pensez-y lorsque vous lisez des études sur 15 ou 20 personnes… Là encore plus la taille d’échantillon est importante et plus la fiabilité augmente.

Pour plus de détails, la chaine YouTube « La statistique expliquée à mon chat » propose une vidéo qui pourrait vous intéresser.

Et la dispersion autour de la moyenne (nommée espérance puisque c’est la valeur la plus probable), notée en écart type, permet d’englober une plus ou moins grande partie de la distribution en tenant compte des variabilités. On considère qu’un écart type couvre 68% de la distribution, deux correspond à 95% et trois à 99,7%.

Grace à ces écarts types il est possible, lorsque l’on confronte une donnée à la distribution de loi normale, de dire si cette donnée semble fiable ou pas (à 68%, 95 ou 99.7%). C’est ainsi qu’il est possible de poser des hypothèses et de les tester. Et gardez à l’esprit que même une étude bien menée et fiable à 99,7% peut produire un résultat faux en étant dans les 0.3%…

On commence par postuler une hypothèse (par exemple que le phénomène A entraine le résultat B). Puis le résultat de l’expérience est mis en lien statistiquement avec le résultat théorique. Si le résultat obtenu n’est pas cohérent, on rejette l’hypothèse. S’il n’est pas incohérent, on ne rejette pas l’hypothèse.

J’insiste sur le fait de ne pas rejeter plutôt que de dire « on valide l’hypothèse » car il serait possible de passer à coté d’une autre explication (par exemple C -> B) et le résultat serait donc cohérent avec notre hypothèse bien que l’hypothèse soit fausse… Jusqu’à preuve du contraire (donc dans un temporaire qui peut être définitif), cette théorie sera utilisable.

Cette notion de fiabilité dans un intervalle de valeurs apparait sous le nom de significativité (significatif statistiquement), noté P. Il est donc important de regarder cette valeur dans une étude. On considère qu’un p <5% est significatif, s'il est supérieur il faudra augmenter la taille de l'échantillon car la différence observée ne sera peut-être due qu'au hasard. Cette vidéo de l’Inserm de moins de 4 minutes qui vous l’expliquera plus en détail.

C’est ici qu’entrent en jeu les biais de confusion. Quelque chose dans l’étude n’a pas été pris en compte et pourtant les résultat vont dans le sens qui nous arrange. Je vais prendre un exemple qui illustre cela très bien : une étude regardait la relation entre nombre de cigognes et nombres de bébés… et effectivement là où il y avait plus de cigognes, il y avait plus de bébés. Donc les cigognes apportent les bébés ? La confusion venait d’un facteur simple. Les cigognes reportées avaient leur nid sur les cheminées. Plus une ville est grande plus il y a de cheminées, donc de cigognes. Mais aussi plus une ville est grande et plus il y a de bébés si on considère le taux de naissance identique dans les différentes tailles de ville… le déterminant n’était donc pas le nombre de cigogne mais la taille de la ville.

Une autre notion importante et même fondamentale est la différence entre la corrélation et la causalité. La corrélation est un lien observé entre deux séries de données. Mais cela n’indique pas si c’est le fruit du hasard ou si un phénomène lie bien les deux séries…

Le site spurious correlations s’est fait une spécialité de dénoncer ces liens qu’il est très tentant de faire entre…

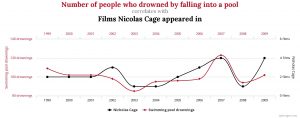

Les noyades par chute dans une piscine et le nombre de films avec Nicolas Cage

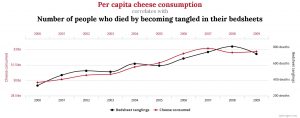

Ou mieux encore, la consommation de fromage et les morts par étouffement dans ses draps qui est encore plus « parlante ».

Comme ces deux infographies issues du site dont je vous ai parlé le montrent, un lien peut être le fruit du hasard. Et c’est un réel problème des études dites observationnelles qui ont tendance à tirer des conclusions rapides au lieu de tester des hypothèses.

Même dans le cas où un lien est fermement établi, il ne faut pas non plus anticiper le sens de cette relation avec un biais d’antériorité. Dit autrement, ce n’est pas parce que cela s’est passé avant que c’est la cause. Cette manière de pensée est anti-intuitive et l’antériorité n’est en rien la preuve de la cause.

Un exemple permettra de mieux comprendre. Imaginez que vous ne connaissiez pas le système de transports en commun. Qu’observe-t-on ? Des gens arrivent à un arrêt de bus, puis le bus vient. Est-ce que ce sont les gens qui font venir le bus ou le bus qui fait venir les gens ? Bien évidemment les gens viennent parce qu’ils savent qu’ils pourront prendre le bus et arrivent en avance pour être sûrs de ne pas le rater… Il faut se méfier des idées reçues et des pensées toutes faites.

Deux choses :

- Ne confondez pas corrélation et causalité ;

- Ne tirez pas de conclusion hâtive sur le sens de la causalité si elle existe.

Enfin, l’économétrie permet de créer des modèles plus complexes d’explication d’un phénomène pouvant intégrer différents facteurs et permet de tester les hypothèses ou l’implication de ces facteurs dans un phénomènes.

Donc non, toutes les études ne se valent pas en terme de qualité de récolte des données, de respect des outils statistiques et des conclusions apportées mais cela fera l’objet d’un autre article.

Ping : Science ou pseudo-science ? - Diét et clic